プレスリリース 2026年

AIデータセンター向けのソフトウエアスタック

「Infrinia AI Cloud OS」を発表

~GPUやKubernetes、AIワークロードの大規模な管理が可能~

2026年1月21日

ソフトバンク株式会社

ソフトバンク株式会社(本社:東京都港区、代表取締役 社長執行役員 兼 CEO:宮川潤一、以下「ソフトバンク」)は、次世代のAI(人工知能)インフラアーキテクチャーやシステムの開発を担当するInfrinia(インフリニア)チーム※1において、AIデータセンター向けのソフトウエアスタック※2「Infrinia AI Cloud OS」を開発しましたのでお知らせします。

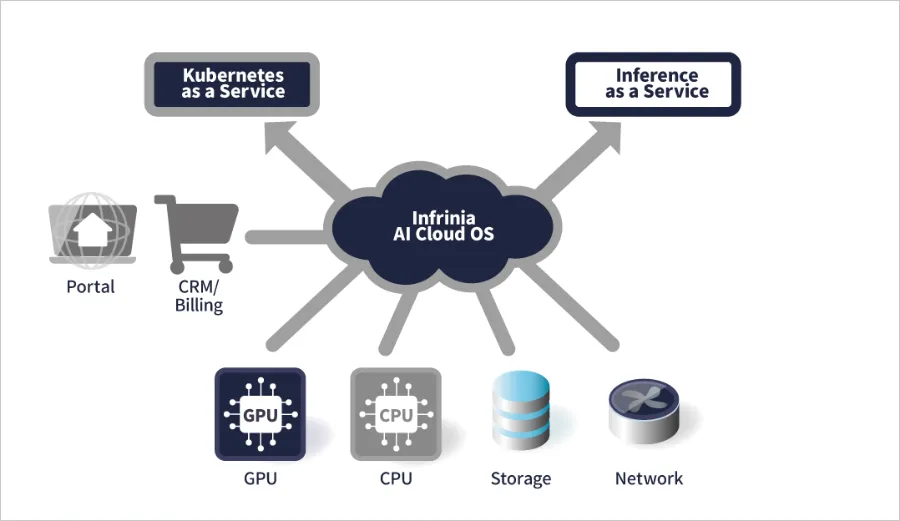

AIデータセンターを運用する事業者は、「Infrinia AI Cloud OS」を導入することで、マルチテナント環境に対応したKubernetes※3 as a Service(KaaS)と、大規模言語モデル(LLM)の推論機能をAPI(Application Programming Interface)として提供するInference as a Service(Inf-aaS)を自社のGPU(Graphics Processing Unit)クラウドサービスの機能として構築することが可能です。また、オーダーメードのソリューションの導入や自社開発をした場合と比較して、TCO(Total Cost of Ownership:総所有コスト)や運用負荷の低減が期待できます。そのため、AIモデルの学習から推論までを効率的かつ柔軟に行えるGPUクラウドサービスを、迅速に提供することが可能になります。

ソフトバンクは今後、自社のGPUクラウドサービスへ「Infrinia AI Cloud OS」を導入する予定です。また、Infriniaチームは、「Infrinia AI Cloud OS」のグローバルでの普及に向けて、海外のデータセンターやクラウド環境への展開を進めていきます。

- [注]

-

-

※1

Infriniaチームは、次世代のAIインフラの推進に向けたソフトバンクの取り組みの一環として、完全子会社であるSB Telecom America Corp. 内に設けられた、インフラアーキテクチャーやシステムの開発を担当するチームです。米国カリフォルニア州サニーベールを拠点として活動しています。

-

※2

ソフトウエアスタックとは、システムやアプリケーションの構築・運用に必要な複数のソフトウエアや機能を組み合わせて提供するものです。

-

※3

Kubernetes(クバネティス)とは、アプリケーションのデプロイやスケーリングを自動化したり、コンテナ化されたアプリケーションを管理したりするためのオープンソースのシステムです。

-

※1

「Infrinia AI Cloud OS」の開発の背景

昨今、生成AIやロボティクス、シミュレーション、創薬、材料開発など、GPUを活用したAI処理の需要が急速に拡大しています。これに伴い、AI処理におけるユーザーの用途や利用形態も多様化・高度化しており、下記のようなニーズが発生しています。

- GPUベアメタルサーバーが抽象化され、GPUクラウドサービス事業者で管理されているインフラの利用

- コスト最適化を実現し、GPUを意識せず利用できる、高度に抽象化された推論サービスの活用

- AIモデルを中央サーバーで学習させて最適化し、エッジAIで推論を行う高度な運用

一方で、このようなニーズに対応したGPUクラウドサービスの構築・運用には、高度な専門知識と煩雑な作業が必要なため、事業者には大きな負担となります。

これらの課題を解決するため、Infriniaチームは、GPUの性能を最大限に引き出しつつ、高度な機能を備えたGPUクラウドサービスの構築・運用を簡便かつ迅速に実現できるソフトウエアスタックとして、「Infrinia AI Cloud OS」を開発しました。

「Infrinia AI Cloud OS」の主な特長

Kubernetes as a Serviceの実現

- 「NVIDIA GB200 NVL72」などの最先端のGPU基盤上で、BIOS(Basic Input Output System)設定からRAID(Redundant Array of Inexpensive Disks)設定、OS構成、GPUドライバー設定、ネットワーク設定、Kubernetesコントローラー、ストレージ設定までを自動化し、物理インフラおよびKubernetesの運用負荷を低減することが可能

- AIワークロードの要件に応じたクラスターの作成・更新・削除時に、ソフトウエア定義によって物理接続(NVIDIA NVLink)とメモリー(Inter-Node Memory Exchange)を動的かつ即座に再構成することが可能

- GPUの近接性やNVIDIA NVLinkドメインに基づく自動ノード割り当てにより、高度に分散されたジョブにおける遅延を低減し、GPU間の接続帯域の活用を最大化

Inference as a Serviceの実現

- Kubernetesや基盤インフラを意識せず、LLMを選択するだけで推論サービスの運用が可能

- OpenAIと互換性があるAPIで、既存のAIアプリケーションのドロップインが可能

- 「NVIDIA GB200 NVL72」などのコアおよびエッジプラットフォーム上で、複数ノード間でのシームレスなスケーリングを実現

セキュアなマルチテナント環境と高い運用性

- 暗号化されたクラスター通信と分離による、テナントの隔離機能の提供

- システムのモニタリングやフェールオーバーなど、運用・保守に関わるメンテナンス作業を自動化

- AIデータセンター事業者の管理画面や顧客管理システム、請求システムと接続するためのAPIを提供

これにより、すでに顧客管理システムなどを持つAIデータセンター事業者や、GPUクラウドサービスを展開する企業などは、GPUのリソースを柔軟に活用しながら、AIモデルの学習から推論までを効率的に行える高度な機能を、自社のサービスに加えることが可能になります。

ソフトバンクの代表取締役 社長執行役員 兼 CEOである宮川潤一は、次のように述べています。

「ソフトバンクは、AIエージェント、フィジカルAIへと進化を続けるAIの活用をさらに深めるため、社会実装する必要な機能として、新たなGPUクラウドサービスおよびソフトウエア事業を開始します。その中核となる自社開発の『Infrinia AI Cloud OS』は、AIデータセンターから企業、サービスプロバイダー、開発者までをシームレスにつなぐ、次世代AIインフラのためのGPUクラウド基盤ソフトウエアです。AIインフラの進化は、GPUサーバーやストレージといった物理的要素に加えて、それらを統合し、柔軟かつ大規模に提供するソフトウエアが不可欠です。ソフトバンクはInfriniaを通して、AI時代のクラウド基盤を担い、社会に持続的な価値を提供していきます」

「Infrinia AI Cloud OS」の詳細は、下記のウェブサイトをご覧ください。

https://infrinia.ai/

- SoftBankおよびソフトバンクの名称、ロゴは、日本国およびその他の国におけるソフトバンクグループ株式会社の登録商標または商標です。

- その他、このプレスリリースに記載されている会社名および製品・サービス名は、各社の登録商標または商標です。